W poprzednim artykule opisywaliśmy techniki genotypowego uwierzytelniania. Dziś z kolei chcielibyśmy przybliżyć tematykę biometrii behawioralnej. Jest to obszar biometrii zajmujący się dokonywaniem pomiarów mierzalnych cech zachowań, które zostały nabyte z czasem, charakteryzują w sposób unikatowy danego osobnika i są wykorzystywane do automatycznego uwierzytelniania.

Metody te bazujące właśnie na analizie sposobu zachowania badanego różnicują ludzi na podstawie zawartości i "sposobu działania ich mózgu". Z tymi metodami wiąże się wielkie nadzieje ze względu na trudność podrobienia (w uproszczeniu) takiego "sposobu działania czyjegoś mózgu". Prawidłowe funkcjonowanie umysłu identyfikowanej osoby determinuje poprawność pracy systemu. Zatem wyklucza się tu identyfikację osób nieprzytomnych albo martwych. Znajdujący się pod wpływem stresu lub środków odurzających, narkotyków, będą łatwo wykrywani ze względu na wyraźne odstępstwa występujące w ich zachowaniu. Jest to niewątpliwie dodatkowy argument przemawiający na korzyść identyfikacji behawioralnej. Trudność z kolei stanowi skomplikowanie w metodach ekstrakcji osobniczych cech behawioralnych, które to niejednokrotnie są obecnie kosztowne i trudne technicznie do zrealizowania. Istnieje wiele metod analizy pracy mózgu (PET - ang. Positron Emission Termography, MRI - ang. Magnetic Rezonans Imaging), lecz w zautomatyzowanej identyfikacji biometrycznej poszukuje się tanich, szybkich i wygodnych rozwiązań dających jednocześnie niepodważalne informacje o cechach osobniczych.

Rozpoznawanie pisma (ang. sign verification)

Według wielu znawców tematu to właśnie charakter pisma jest wiarygodnym odzwierciedleniem kwintesencji osobowości. Metody badania związków i zależności pomiędzy cechami graficznymi pisma a osobowością człowieka wyznaczyły kierunek nowej dziedzinie nauki, jaką jest grafologia. Dotarliśmy do informacji mówiących, że aż w 95% dzięki analizie pisma można poznać czyjeś usposobienie, temperament, ambicje, zdolności, a także obszar uczuć i emocji oraz świat wartości i motywacji. Zaskakująco wiele informacji - to tak jakby nasz charakter pisma był jedną z bram do naszej duszy. Dlatego też grafologia wykorzystywana jest m.in. w kryminalistyce jako element identyfikacji personalnej oraz w zakresie ekspertyzy dokumentów, w psychologii sądowej do sporządzania portretu psychologicznego przestępcy i w selekcji zawodowej, a także w szkolnictwie jako nieinwazyjny sposób psychologicznego diagnozowania, pozwalający na rozpoznanie talentów i predyspozycji uczniów, co może im pomóc w wyborze kierunku studiów lub zawodu.

Umiejętność kaligrafowania łączyła kiedyś i fascynowała wszystkich wykształconych Chińczyków. Oni to już kilka tysięcy lat temu analizowali charakter pisma, kaligrafię, dając odpowiedzi na pytania dotyczące osobowości. Analizą pisma i znajdywaniem zależności z charakterem człowieka interesowali się również Egipcjanie oraz tak wielcy filozofowie greccy jak np. Arystoteles (384 p.n.e. - 322 p.n.e.) czy Heraklit z Efezu (540 p.n.e. - 480 p.n.e.). W 1622 roku ukazał się prawdopodobnie pierwszy zapis źródłowy poświęcony grafologii, w postaci książki autorstwa włoskiego profesora medycyny Camillo Baldi z Bolonii. W kolejnych latach wielu innych naukowców i myślicieli, zajmowało się tym zagadnieniem, traktując je jako jeden z rodzajów indywidualnej ekspresji. Jednak ich metody badań wykorzystywały głównie symbolikę pojedynczych znaków i były wciąż nie dość rozwinięte. W następstwie tego wiek XIX okazał się wiekiem rozkwitu grafologii. W 1871 roku w Paryżu francuski mnich Jean Hyppolyt Michon (1806-1881), który przez lata zajmował się gromadzeniem i porządkowaniem rękopisów, katalogując je według zespołów cech i opatrując komentarzami, ogłosił narodziny dziedziny nauki tak właśnie w owym czasie nazwanej.

| Jak ważną dziedziną w bezpieczeństwie jest grafologia postaramy się zilustrować na przykładzie najsłynniejszego w ostatnich latach przypadku sfałszowania charakteru pisma, a mianowicie tzw. sprawy rzekomych pamiętników Adolfa Hitlera. Pamiętniki "odnalazły się" na początku lat 80. ubiegłego wieku i zostały najpierw sprzedane za prawdopodobnie 6 milionów marek, następnie odsprzedawane we fragmentach za kolejne zawrotne, bajońskie sumy. Ekspertyzy czołowego grafologa Kennetha Rendella z Bostonu, posługującego się potężnym mikroskopem (niezbędnym przy analizie różnych sposobów łączenia liter) i próbkami oryginalnego własnoręcznego pisma Hitlera wykazały wiele istotnych różnic w pisowni (zwłaszcza w przypadku wielkich liter: E, H, i K) oraz to, że fałszerze posłużyli się współczesnym atramentem. Wątpliwości budził także rodzaj papieru (zwykły, liniowy, tani papier), gdy Hitler, kiedy na początku lat 30. robił notatki, używał tylko papieru najlepszej jakości, ze złotymi tłoczeniami. Po wykryciu tej mistyfikacji wszczęto dochodzenie, które doprowadziło do aresztowania wielokrotnie karanego niemieckiego przestępcy Konrada Paula Kujana oraz jego dwóch wspólników. |

Jego najwybitniejszy następca, Jean Crépieux-Jamin (1858-1940), kontynuując dzieło mistrza, ustalił siedem kryteriów klasyfikacji pisma: kształt, kierunek, rozmiar, nacisk, szybkość, ciągłość i układ pisma. Jednocześnie na przełomie XIX i XX wieku w Niemczech powstał drugi ośrodek rozwoju grafologii w Europie, Niemieckie Towarzystwo Grafologiczne, w którym to psycholog i filozof Ludwig Klages, zajmując się badaniem zależności między mową, mimiką a pismem, stworzył naukowe podstawy grafologii. Jednakże zasadnicze osiągnięcia w interpretacji pisma przyniosły dopiero ostatnie dziesięciolecia. Analizując pismo, bada się: warstwy: graficzną, treściową, językową oraz techniczną, która ma na celu ustalenie czasu i sposobu powstania pisma.

Niejednokrotnie, zanim człowiek nauczył się pisać, już składał w najróżniejszych okolicznościach podpisy odręczne w postaci tzw. paraf (krzyżyków), których forma graficzna była raczej prymitywna niż szczególna, by móc uznać ich przydatność identyfikacyjną. Jednakże rozpowszechnienie umiejętności pisania (likwidacja analfabetyzmu) spowodowało wyróżnienie dwu niezależnych od siebie sposobów przekazu informacji: określonej treści i nadanej podpisowi, szczególnej formy graficznej. Żadna cecha tego podpisu (pisma) nie jest indywidualna, charakterystyczna tylko dla jednej osoby. Dopiero odpowiednio duży zespół cech nadaje podpisowi odręcznemu jego indywidualny charakter (indywidualny zespół cech - zespół cech graficznych, językowych lub treściowych, który występuje w próbkach pisma tylko jednego wykonawcy. Wskazanie takiego zespołu cech jest warunkiem indywidualnej identyfikacji wykonawcy podpisu, pisma). Dlatego też zarówno w tradycyjnych badaniach pisma, jak i w systemach automatycznych powinno się analizować jak najwięcej cech. W miarę bowiem zmniejszania się liczby badanych cech podpisu (pisma) rośnie ryzyko pomyłki w identyfikacji składającego podpis. Z powyższego wynika, że należy dbać o to, by składający podpisy odręczne pospisywali się czytelnie, pełnym imieniem i nazwiskiem, dodatkowo np. składając obok parafę.

W automatycznych systemach biometrycznych analiza podpisu powinna uwzględnić tak wiele cech graficznych jak to tylko możliwe. Powinny być też analizowane zarówno cechy statyczne, jak i dynamiczne podpisu. Według Anny Koziczak (Warunki akceptacji biometrycznego badania podpisu, Techniki Komputerowe, nr 1/2001, Wyd. Instytu Maszyn Matematycznych) warto rozszerzać te analizy jeszcze o grupę tzw. cech topograficznych (układ liter względem siebie, układ poszczególnych znaków i całego podpisu względem liniatury, rozmieszczenie podpisu w prostokącie wyznaczającym miejsce na podpis, kształt linii podpisu itp.). Są one szczególnie istotne w badaniu autentyczności podpisów z powodu ich wyjątkowo rzadkiego uwzględniania, naśladowania przez fałszerzy.

Grafolodzy utrzymują, że podczas pisania podświadome treści przekazywane są do palców dłoni i przelewane na papier. Wykorzystują oni w pracy skomplikowane maszyny i urządzenia, takie jak skanery działające w ultrafiolecie i podczerwieni, dzięki którym można odczytać litery wymazane bądź zmienione; przyrządy dzielące obraz na pół, służące do ciągłego porównywania oryginału z domniemanym falsyfikatem. Sfałszowany podpis nie ma tej szybkości, płynności i nie jest tak gładki jak oryginał. Wyraźnie widać tępe początki i zakończenia linii, niedokładne krzywizny, niepotrzebne przerwy czy oznaki drżenia ręki. Dwie litery mogą mieć identyczny kształt, ale zawsze można powiedzieć, która z nich została napisana szybko, a która ostrożnie nakreślona. Charakter pisma jest odzwierciedleniem charakteru i potencjału człowieka. Większość grafologów jest zgodna co do tego, że właściwie charakter człowieka można ocenić jedynie, uwzględniając wiele czynników. Eksperci wyróżniają w odręcznym piśmie trzy strefy: górną i dolną, które obejmują zakończenia wielkich liter oraz znaków takich jak b, d, g itp., oraz środkową zawierającą pozostałe małe litery. Różnice pomiędzy formą i wielkością tych stref są jakoby odzwierciedleniem prawdy o człowieku. Pokaźna strefa górna wskazuje na człowieka pogodnego i otwartego; niewielka dolna strefa - płytkiego i niedojrzałego emocjonalnie; przeciętna strefa środkowa natomiast charakteryzuje osobę praktyczną i dobrze zorganizowaną. Według prof. Mirosława Owoca, biegłego sądowego w dziedzinie ekspertyzy dokumentów, rola tradycyjnego podpisu jako podstawy identyfikacji, wynikającej z jego formy graficznej jak również z jego treści (zob. M. Owoc: Zmierzch podpisu tradycyjnego, [w:] Biometria. Wybrane zagadnienia, red. A. Mitas, Cieszyn-Warszawa, 2004, [reprint]) zmalała tak dalece, że należy poszukiwać innych sposobów "podpisu".

Zautomatyzowane badania rozpoznawania podpisu zaczynają się w 1965 roku, kiedy to północnoamerykańskie lotnictwo rozwinęło pierwszy system rozpoznający podpis (A.J. Mauceri, Feasibility Studies of Personal Identification by Signature Verification, Report no. SID 65 24 RADC TR 65 33, Space and Information System Division, North American Aviation Co., Anaheim, USA, 1965.). Z kolei w 1977 roku firmie Veripen Inc. przyznano patent dotyczący urządzenia identyfikacji personalnej, które pozyskiwało unikatową, cyfrową charakterystykę analizy dynamicznego nacisku pióra.

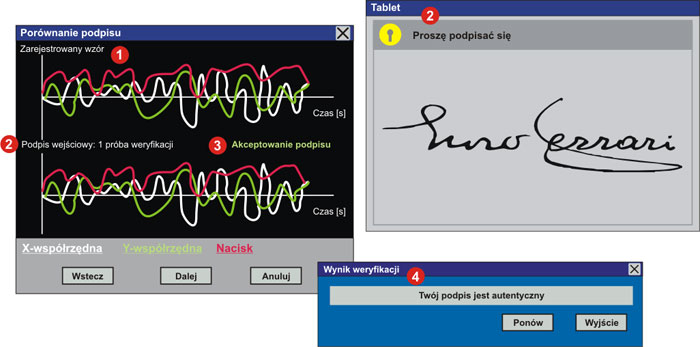

Jak już wspomnieliśmy, uwierzytelnianie podpisu było wykorzystywane od wieków, ale novum w sferze podpisywania, biometryczna weryfikacja podpisu, oprócz wyglądu podpisu i treści, uwzględnia nowatorskie podejście, właśnie takie elementy jak dynamikę jego składania, czyli: szybkość i kolejność pisania, siłę nacisku w poszczególnych punktach, a nawet nachylenie narzędzia piszącego. Konwersję podpisu ręcznego do postaci cyfrowej realizuje się za pomocą specjalnych tabliczek (ang. tablets - podpis elektroniczny/niecyfrowy posiadający status prawny), narzędzi piszących (piór umożliwiających pomiar tych parametrów) albo rozwiązań niezależnych od sprzętu - programowych.

Dane pochodzące z tabletu można potraktować jako zestaw odrębnych sygnałów w czasie. Są one następnie używane do wyznaczania unikatowych cech podpisu danej osoby.

W praktyce łączy się metody analizy podpisu, statyczną z metodą dynamiczną. Po wprowadzeniu podpisu usuwany jest szum informacyjny (zakłócenia) dotyczący zarówno podpisu, jak i sposobu podpisywania się. Następnie wyszukiwane są punkty charakterystyczne i porównywane z zapamiętanym wzorcem. Taka kombinacja analizy statycznej i dynamicznej minimalizuje zarówno liczbę fałszywych odrzuceń, jak i fałszywych akceptacji. Na rynku komercyjnym możemy odnaleźć kilka wersji systemów weryfikacji podpisu odręcznego np. firm MotionTouch, SignPlus, SoftPro czy CyberSign Japan Inc.

Rozpoznawanie odgłosu składania podpisu odręcznego (ang. Sound Signature Technology, SignHear)

System weryfikacji podpisu SignHear to technologia opatentowana przez firmę Sign Assured Ltd., wykorzystująca rozpoznawanie dźwięku, jaki wydobywa się podczas składania ręcznego podpisu, do weryfikacji tożsamości osoby podpisującej się. Kombinacja ruchu po powierzchni urządzenia tworzy zestaw dźwięków, unikatowych dla każdego człowieka. Stworzenie jego repliki jest prawie niemożliwe. Prawdą jest, że podpisy będą się różnić (graficznie) nawet jeśli wykona je ta sama osoba, jednak pewien wzór tego, w jaki sposób powstaje podpis, pozostaje ten sam. Przechwycenie dźwięków podpisu wymaga twardej powierzchni. W wypadku urządzenia SignHear jako powierzchnię, na której składa się podpis, wykorzystuje się stalową podkładkę. Jest to biometryczne urządzenie (czujnik pokryty metalem) odpowiednie dla licznej grupy środowisk, począwszy od biura, urzędu i fabrycznej podłogi do zastosowań wojskowych. Technologia może być z powodzeniem wykorzystywana w kontroli dostępu oraz rejestracji czasu pracy, a także logowaniu do PC i w innych zastosowaniach. Produkt zaprezentowano na tegorocznych targach Air & Port Security Expo Europe, które odbyły się 13-14 września w Brukseli.

Weryfikacja głosem (ang. voice verification) i identyfikacja mówiącego (ang. speaker identification)

Poświadczenie tożsamości przy wykorzystaniu głosu mówiącego jest zdefiniowane jako zautomatyzowane sprawdzanie tożsamości osoby, na podstawie unikatowej charakterystyki jej głosu. Wystarczy prosty mikrofon, aby zarejestrować głos i następnie użyć jednego z wielu algorytmów analizujących widmo sygnału mowy/głosu. Nie należy mylić techniki rozpoznawania mówiącego/głosu z rozpoznawaniem mowy. Rozpoznawanie mowy to analiza tego, co mówimy, a nie potwierdzenie naszej tożsamości. Jednoczesna analiza naszego głosu (tego, w jaki sposób mówimy) i mowy (tego, co mówimy) może być wykorzystana, by stworzyć lepszy system biometrycznego uwierzytelniania.

Identyfikacja mówiącego jest czymś powszechnym i proces ten przeprowadzany jest przez nas codziennie. Gdy rozmawiamy przez telefon, niejednokrotnie już po wypowiedzeniu pierwszych słów przez rozmówcę jesteśmy w stanie go zidentyfikować zmysłami. Jednocześnie zdarzyło się nam, że spotkaliśmy nieznaną osobę, której głos był w naszym przekonaniu taki sam, bądź też niezwykle podobny do głosu, który dobrze znamy. A więc nasze zmysły nie dają zadawalająco wysokiego wskaźnika akceptacji.

Dokładne badania analizy sygnału mowy wykazały, że wypowiedzi tej samej treści dowolnych dwóch osób różnią się od siebie pod względem mierzalnych cech fizycznych. Dzieje się tak za sprawą specyficznych cech narządu mowy, który wraz z ośrodkiem mowy w mózgu tworzy unikatowy, psychofizyczny aparat wytwarzania sygnału mowy. Przetwarzaniem sygnału mowy zajmuje się szereg dziedzin, pośród których wyróżnić można trzy główne nurty: analizę/syntezę mowy, rozpoznawanie mowy i mówcy oraz kodowanie mowy. W biometrii wykorzystywane są algorytmy przetwarzania mowy zmierzające do identyfikacji bądź weryfikacji tożsamości mówiącego, co sprowadza się do poszukiwania i wydobycia z sygnału mowy takiego zestawu mierzalnych cech osobniczych, które są indywidualne i niepowtarzalne dla każdego mówcy. Niestety, na skuteczność tego procesu, podobnie jak w przypadku innych technik biometrycznych, wpływa wiele czynników towarzyszących procesowi akwizycji próbki biometrycznej głosu. Powodują one, że dwie wypowiedzi tej samej treści i tej samej osoby zarejestrowane w różnym czasie również różnią się od siebie. Stopień tych różnic jest przy tym zmienny i zależy od wielu czynników związanych bądź z samym procesem akwizycji (szumy, zakłócenia w torze fonicznym), bądź też ze stanem emocjonalno-zdrowotnym mówcy (przeziębienie, stres etc.). Dlatego też w procesie autoryzacji wykorzystuje się cechy będące w powiązaniu z procesem wytwarzania mowy, a nie ekstrahowane bezpośrednio z sygnału mowy.

Analiza sygnału mowy dotyczy z reguły jego struktury czasowo-częstotliwościowej, ściśle uzależnionej od wielu zjawisk towarzyszących procesowi wytwarzania mowy. W tym złożonym procesie wyróżnia się dwa czynniki powstawania (niepowtarzalnych) cech charakterystycznych sygnału mowy: fizyczne i psychiczne (wyuczone). Aspekt fizyczny obejmuje budowę traktu głosowego, którego wymiary i kształt (jamy gardłowej, nosowej, jamy ustnej, długości i napięcie strun głosowych zlokalizowanych w krtani) są najbardziej znaczącymi czynnikami kształtującymi cechy wypowiedzi i nadającymi jej indywidualny charakter. Prawdopodobieństwo odnalezienia dwóch osobników, u których trakty głosowe byłby identyczne co do kształtu i wielkości, jest znikome. Drugi czynnik w określaniu niepowtarzalności głosu leży w sposobie mowy, powiedzielibyśmy manierze, która wpływa na manipulację narządami artykulacji lub mięśni mowy podczas wydawania dźwięków. Artykulatory te obejmują wargi, zęby, język, podniebienie miękkie i mięśnie szczęki, których to sterowane przez nas, wzajemne oddziaływanie daje w efekcie zrozumiałą mowę. Zrozumiała mowa jest rozwinięta przez przypadkowy proces uczenia się, naśladowania innych, którzy komunikują się. Prawdopodobieństwo, że dwie osoby mogłyby rozwinąć identyczne wzory użycia ich artykulatorów, też jest znikome. A uwzględniając obydwa czynniki, możemy uznać, że głos jest z pewnością unikatową cechą każdego człowieka.

Pierwszy model akustyczny mowy zostaje stworzony w 1960 roku. Wtedy to szwedzki profesor Gunnar Fant opublikował model opisujący fizjologiczne komponenty akustycznego rozpoznawania mówiącego. Jego wnioski wynikały z wykorzystania promieni Roentgena w analizie osobników generujących wyszczególnione fonie dźwięków. Wyniki badań pozwoliły lepiej zrozumieć biologiczne komponenty mowy, wpływ budowy traktu głosowego na dźwięk mowy. Szesnaście lat później Texas Instruments rozwinął pierwszy prototypowy system rozpoznawania mówiącego, który był testowany przez US Air Force i MITRE Corporation.

Co to jest weryfikacja głosu (ang. voice verification)? Jest to proces porównania uzyskanej nowej próbki głosu z przechowywanym, cyfrowym modelem głosu albo wzorem głosu (voiceprint), do celów uwierzytelnienia tożsamości (identyfikacji 1:N oraz weryfikacji 1:1).

Jaka jest różnica pomiędzy właśnie identyfikacją (speaker verification) a weryfikacją (speaker identification) mówiącego? Przy weryfikacji głosem tożsamość jest potwierdzona przez dopasowanie głosu osoby do pojedynczego wzoru głosu przechowywanego w bazie. Jest to typowy proces weryfikacji tożsamości, gdzie weryfikowany podaje z góry ustaloną informację, np. numer konta lub hasło (jest to dodatkowy identyfikator), która po analizie głosu porównywana jest ze sporządzonym wcześniej wzorcem. Serwer działa w trybie sprawdzania głosu.

W identyfikowaniu mówiącego uzyskany wzorzec głosu jest dopasowany do kilku wzorców. Jest to typowo proces, w którym żaden inny identyfikator nie jest dostępny, tak jak w wypadku prowadzenia nadzoru/inwigilacji audio albo kiedy użytkownik systemu zapomniał hasła czy numeru konta. Zarówno sprawdzanie mówiącego, jak i jego identyfikowanie to typy biometrii głosu. Weryfikacja głosem to proces porównania uzyskanej próbki głosu z przechowywanym, cyfrowym modelem głosu albo wzorcem głosu do weryfikacji tożsamości.

Większość systemów weryfikacji głosu wykorzystuje tzw. tekst zależny: użytkownik musi podać określone słowo, wyrażenie (hasło) albo algorytm cyfr, by został zweryfikowany. Jest to przykład łączenia naszej unikatowej wiedzy (pośredni poziom bezpieczeństwa, zob. art. z poprzedniego numeru.) z tym, kim jesteśmy i co robimy - biometrią (najwyższym poziomem bezpieczeństwa). Istnieje również kilka systemów biometrii głosu, które pracują, wykorzystując tzw. tekst niezależny, tzn. że mówiący może być weryfikowany dzięki jakiejkolwiek próbce głosu. Ten typ systemu jest najbardziej odpowiedni dla systemów, które w pracy bazują na analizie interesujących nas sygnałów na tle sygnałów otoczenia, niekoniecznie dla nas istotnych, gdy nie mamy możliwości sprowokowania interesującej nas osoby do wypowiedzenia odpowiedniej frazy, będącej jej identyfikatorem, i w dodatku w środowisku pozbawionym dodatkowych dźwięków. W sytuacji, gdy dwie osoby szepczą przy szumie lecącej z kranu wody, system ten przez "inteligentną" analizę sygnału jest w stanie określić, co powiedziała każda z osób, z łącznym dokonaniem ich identyfikacji, oraz co "powiedziała" woda.

Należy również zwrócić uwagę na to, że niektóre z części traktu głosowego, wpływające na sporządzenie wzorca głosu, są wrażliwe na zmiany pogody, a - ściślej mówiąc - na zimno. System analizy głosu może jeszcze weryfikować osobę, która jest przeziębiona, lecz poważne choroby gardła, takie jak zapalenie krtani, mogą zafałszować wyniki uwierzytelniania. Nie znaleźliśmy danych na temat tego, czy system jest w stanie weryfikować będących pod wpływem alkoholu, ale wydaje się zasadne z punktu widzenia bezpieczeństwa, że system odrzuca takie osoby.

Podczas przygotowywania materiałów do tego artykułu znaleźliśmy szacunkowe dane, z których wynikało, że w bieżącym roku więcej niż 15 milionów Amerykanów stanie się ofiarami kradzieży ID i przedsiębiorcy stracą miliardy bilionów przez oszustwa związane z kradzieżą tożsamości (kradzieżą haseł, PIN-ów, utratą kart). Zdolność weryfikowania tożsamości nigdy nie była tak ważna jak dziś, u progu tworzenia się społeczeństw informacyjnych. Zatem z uwagi na rosnące zagrożenia na rynku biometrycznych zabezpieczeń pojawia się wiele rozwiązań wykorzystujących uwierzytelnianie głosu. Dla przykładu kanadyjska firma Diaphonics, Inc. oferuje rozwiązanie o nazwie SpikeServer. Jest to komputer i zintegrowana z nim platforma programowa, które weryfikują tożsamość biometrycznym sprawdzaniem głosu. Sprawdzanie głosu jest zdecydowanie bardziej bezpieczne i wygodne niż obecnie stosowane telefoniczne metody weryfikacji tożsamości. Dodatkowo przy weryfikowania tożsamości SpikeServer nagrywa transakcje głosowe, tworząc dziennik kontroli wszystkich interakcji użytkownika/klienta z systemem. Przebieg procesu ilustruje rysunek 4. Kiedy użytkownik telefonuje np. do banku, system prosi go o podanie ustalonej, pojedynczej informacji, np. numeru swojego konta lub telefonu, która jest jego swoistym identyfikatorem. Na podstawie tej informacji system sprawdza w bazie danych, czy dany klient jest zarejestrowany w systemie. Jeżeli w bazie nie ma odpowiedniego rekordu, system może przeprowadzić proces rejestracji nowego użytkownika. Dzwoniący powtarza pojedynczą informację identyfikującą, by system mógł nagrać głos i dokonać próbkowania (do postaci cyfrowej) jego unikatowych części charakterystyki częstotliwościowej, tworząc wzór głosowy.

Następnie system przeprowadza proces weryfikacji, porównując informację identyfikującą oraz uzyskany nowy wzór głosowy z rekordem bazy danych dzwoniącego. Jeśli oba wzory pasują do siebie, SpikeServer pozwala dzwoniącemu wejść do systemu. Jeśli nie ma dopasowania, dzwoniący skierowany jest ponownie do kroku pierwszego operacji lub proszony jest o rozłączenie się.

Identyfikowanie przy użyciu voiceprint może być zdefiniowane jak kombinacja: dźwiękowego (nasłuchowego) i spektrografowego (instrumentalnego) porównania jednego lub więcej głosów znanych z nieznanym w celu identyfikacji albo eliminacji. System taki został rozwinięty przez Bell Laboratories w późnych latach 40. ubiegłego wieku na potrzeby wywiadu wojskowego. Możliwość wykorzystania do celów sądowych zauważono w późnych latach 60., kiedy to system ten został zaadaptowany przez policję stanową stanu Michigan. Od roku 1967 aż do dziś wykorzystano tę metodę w ponad 5000 sprawach sądowych. Identyfikowanie głosu stosowano w rozmaitości sprawach karnych, włączając morderstwa, porywania, wymuszenia, przemyt narkotyków, zakłady i hazard, korupcję polityczną, pranie brudnych pieniędzy, uchylanie się od podatków, włamania, groźby bombowe, akcje terrorystyczne i działalność przestępczości zorganizowanej. Akustyczna analiza dźwięków, która włączając filtrację i wzmocnienie poszczególnych dźwięków nagrania, poświadczenie autentyczności nagrania, badanie akustyki np. wystrzału, rekonstrukcję rozmów i analizę jakiegokolwiek innego zakwestionowanego zdarzenia akustycznego, niejednokrotnie stanowi niepodważalne (tzw. twarde) dowody w sądzie.

Rozpoznawanie chodu (ang. gait recognition, gait signature)

Rozpoznawanie chodu to proces identyfikowania osobnika na podstawie sposobu poruszania się. Metoda ta oferuje możliwość identyfikacji na odległość, a więc jest bezinwazyjna i bezkontaktowa (nie ma interakcji z urządzeniem biometrycznym). Już z daleka wiemy, z kim mamy do czynienia. Monitorowany nie musi o tym wiedzieć, a więc nie musi zachowywać się w sposób szczególny (wymuszony przez daną metodę biometryczną), jak to jest w przypadku innych technik biometrycznych. Trudno jest zamaskować nasze maniery poruszania się, bo przecież musimy chodzić, w porównaniu np. z pokazywaniem twarzy. Jeszcze trudniej naśladować czyjś chód tak, by sensory i algorytmy komputerowe tego nie wykryły - przecież oprócz indywidualnej motoryki chodu i budowy ciała ruch zależy od indywidualnego "charakteru", umysłu. Istnieje możliwość rozpoznawania sposobów poruszania się na podstawie analizy obrazów o niskiej rozdzielczości i zakłóconych, co z pewnością klasyfikuje tę metodę wysoko w środowisku biometrycznego uwierzytelniania.

Głównym problemem analizy chodu jest fakt, że choć każdy ma wystarczająco unikatowy chód, by moc być w ten sposób rozpoznawanym w idealnych warunkach, to zmiana warunków (np. ubrania, sposobu oświetlenia, kąta "patrzenia" kamery, kontrastu pomiędzy osobą a otoczeniem czy nawet szybkości ruchu etc.) może nastręczać dużo trudności już przy analizie chodu tej samej osoby, a co dopiero różnych. Co więcej, ludzie celowo (lub pod wpływem alkoholu) mogą zmieniać swoje maniery ruchowe, co wpłynie negatywnie na identyfikowanie poszukiwanych.

Najbardziej obiecujące obecnie obszary analizy chodu to rozwiązania medyczne rozpoznające oznaki chorób ruchu. W tej chwili badania związane z automatycznym rozpoznawaniem osób są przeważnie na etapie rozwiązań laboratoryjnych i aplikacje komercyjne, z tego, co wiemy, nie są jeszcze dostępne. Dla przykładu, gdy Instytut Technologii w amerykańskim stanie Georgia rozwijał metodę rozpoznawania ludzi pośród tłumu, szacowano skomercjalizowanie produktu po upływie około pięciu lat, więc wydaje się, że najbardziej prężnie działające ośrodki potrzebują jeszcze kilku lat na wypuszczenie gotowego produktu na rynek zabezpieczeń. Ogólnie identyfikacja na podstawie ruchu, po pierwsze, opiera się na wykryciu ruchu, a więc na technikach detekcji ruchu w obrazie, po drugie, na wiedzy dotyczącej motoryki ruchu, wiedzy medycznej i psychofizycznej, a po trzecie, na analizie zmiany przestrzennego położenia ciała i jego poszczególnych części w czasie.

Z zarejestrowanego filmu wideo analizowane są sekwencje klatek (obrazy) w celu wyodrębnienia postaci człowieka w różnych fazach chodu. Następnie wyodrębniany i opisywany jest ruchomy kształt, dokonywane jest przekształcenie sylwetki i pomiary w celu ekstrakcji pożądanych cech. Zwykle dodatkowo stosuje się metody uproszczenia danych i redukcji szumów. Przekształcenie sylwetki wykorzystuje się do operacji binaryzacji lub oznaczenia konturów. Binaryzacja jest operacją, która praktycznie zawsze występuje w procesie obróbki obrazu, a której celem jest znaczna redukcja zawartej w obrazie informacji. Najczęściej jest realizowana przez progowanie (thresholding). Piksele, których odpowiedni atrybut, np. jasność, przekracza pewien ustalony poziom, są kwalifikowane do jednej grupy, pozostałe zaś do drugiej. Wynikiem binaryzacji są zatem obrazy binarne, czyli takie, w których próbki obrazu mają tylko jedną z dwóch wartości. Podstawowym problemem techniki binaryzacji jest odpowiedni dobór wartości progu. Metody jego doboru można podzielić na zmiennoprogowe i automatyczne.

Ostatnim etapem tej analizy jest klasyfikacja danych i podjęcie decyzji o ich akceptacji bądź też odrzuceniu.

Istnieje podejście do analizy chodu bazujące na "zawartości ruchu" w badanych obrazach, czyli obliczeniu różnic w położeniu punktów składających się na kształt w poszczególnych fazach albo symetrycznych właściwościach chodu, czyli badaniu symetrii punktów składających się na kształt w poszczególnych fazach ruchu. Inne podejście do zagadnienia to wykorzystanie modeli ruchu lub budowy człowieka. Po zlokalizowaniu w obrazie części ciała, np. głowy, bioder, kolan i stóp, mierzy się składowe chodu, np. nachylenie miednicy względem pionu, stopień zgięcia w kolanie oraz położenie względem siebie głowy i nóg lub kąt zawarty pomiędzy osiami części udowych nóg. Wybór tych składowych jest uzależniony od realnych możliwości ich automatycznego postrzegania, możliwości ekstrakcji lub poddania opisowi. Niestety, niektóre elementy składowe chodu widoczne są tylko z góry, tj. znad głowy idącego. Dodatkowo wysoce indywidualne zmiany położenia miednicy, tułowia i ruchy kostki trudno zmierzyć. Według znawców tematu, indywidualność przypisać można dopiero zespołowi dwudziestu charakterystycznych składowych cech.

Informacji o charakterze dynamicznym ruchu dostarcza nam również tzw. ichnogram, czyli ścieżka chodu, która obejmuje zespół śladów kilku kroków. Na podstawie obrazu chodu można określić wiele elementów dotyczących osoby, która pozostawiła ślad. Elementy te to głównie: kierunek chodu, linia chodu, linia stopy, kąt stopy, kąt kroku, długość i szerokość kroku oraz długość i szerokość stopy lub spodu. Badania tych zespołów mogą dostarczyć cennych informacji nie tylko o osobie sprawcy, ale i o przebiegu zdarzenia.

Analiza obrazu ścieżki chodu, czyli ichnogram, z zasady pozwala na identyfikację grupową osoby poruszającej się oraz określenie zachowania się lub okoliczności towarzyszących jej ruchowi (zmian tempa, obciążenia, pewne anomalie ruchowe itp.). Badania prowadzone jednak nad mechaniką i dynamiką chodu dostarczają podstaw do twierdzenia, że analiza ichnogramu może także umożliwić identyfikację indywidualną człowieka - głównie metoda kinematograficzno-dynamograficzna, która uwzględnia nacisk i jego rozłożenie na podłoże - co pozwala na wskazanie konkretnej osoby pozostawiającej ślad traseologiczny.

W systemach automatycznej identyfikacji bada się zatem również takie elementy biomechaniki chodu jak długość kroku, szerokość kroku, kąt stopy, rozkład siły nacisku stopy na podłoże oraz ciężar osoby. Jest to wykorzystanie już istniejącego dorobku innej dyscypliny, traseologii. Traseologia jest częścią kryminalistyki, zajmuje się identyfikacją śladów stóp odzianych i obutych, a także tropów zwierząt z odpowiednim materiałem porównawczym. Rodowodem swoim sięga czasów paleolitycznych, gdzie w sensie kryminalistycznym tropy zwierząt i ślady stóp były pierwowzorem wszelkiej identyfikacji, na wiele tysiącleci przed pojawieniem się naukowych metod identyfikacji.

Niewątpliwie zautomatyzowanie rozpoznawanie chodu jest wielce obiecującą techniką i pojawienie się aplikacji komercyjnych z pewnością wyjdzie naprzeciw oczekiwaniom wzrostu bezpieczeństwa w obiektach użyteczności publicznej jak lotniska, banki, stadiony.

Rozpoznawanie ruchu oka (ang. eye-movements recognition)

Kilku uczonych z Uniwersytetu Joensuu w Finlandi (Roman Bednarik, Tomi Kinnunen, Andrei Mihaila oraz Pasi Fränti) zaproponowało wykorzystanie w biometrii unikatowych cech ruchu gałki ocznej.

Oczy wyposażone są w skomplikowany system sterowania ich ruchem zwany układem okulomotorycznym składającym się z trzech wzajemnie współpracujących par mięśni: pionowych, poziomych i skośnych. Układ ten, bardzo dobrze unerwiony, jest jednym z najszybszych i najbardziej precyzyjnych układów mięśniowych człowieka.

Jego analiza wykazała, że ruchy gałki ocznej składają się z ciągu następujących po sobie stanów stabilizacji, tzw. fiksacji, i szybkich zmian położenia oka, tzw. sakad. Pomiary biometryczne polegają na zarejestrowaniu w zdefiniowanym czasie osobniczych ruchów oka osoby podlegającej rozpoznaniu i podjęciu na tej podstawie decyzji co do tożsamości, jej akceptacji bądź odrzucenia przez system.

Dane pomiarowe systemu rozpoznawania ruchu oka to: rozmiar i dynamika zmian źrenicy, szybkość zmian położenia oka oraz sposób odbicia wiązki podczerwieni. Umożliwiają pomiar osobniczo specyficznych parametrów mechaniki ruchu oka człowieka przy wykorzystaniu wysokiej rozdzielczości. Mniejsza rozdzielczość systemu umożliwia szczegółową analizę interakcji pomiędzy człowiekiem a prezentowanym na monitorze komputera materiałem graficznym. Zastosowanie systemu pomiarowego ruchu oka zapewnia, w odróżnieniu od innych metod o charakterze statycznym, genotypowym, jak linie papilarne lub dno oka, realizację dynamicznej identyfikacji osobniczej wymagającej pełnego zaangażowania w ten proces pracy mózgu. Rozwiązanie takie umożliwia równocześnie określenie stanu emocjonalnego człowieka, stwierdzenie wpływu wszelkiego rodzaju używek jak alkohol, narkotyki lub lekarstwa.

Istnieje kilka różnych metod pomiarów cech osobniczych ruchu gałki ocznej. Np. polegająca na pomiarze napięcia pomiędzy rogówką a dnem oka tzw. metoda elektrookulograficzna. Do przeprowadzenia pomiaru wykorzystuje się także kamery służące do identyfikacji i śledzenia zmian położenia źrenicy oka. Jednak są to metody zbyt mało precyzyjne, by wyznaczyć cechy unikatowe. Najpopularniejsza wydaje się metoda oparta o analizę sposobu odbicia wiązki podczerwonej od gałki ocznej (analiza różnicowa sygnału IR wysłanego i odebranego). Nadajnik IR emituje wiązkę światła podczerwonego, która odbita od rogówki lub twardówki odbierana jest przez odbiornik (detektor podczerwieni ustalający moc sygnału). Ruch oka powoduje zmianę odbicia wiązki IR, co wpływa na ilość podczerwieni defekowanej przez detektor. System interpretuje tę informację, by określić kierunek i zakres ruchu oka.

Ekstrakcja cech osobniczych z sygnału ruchu gałki ocznej jest elementem najtrudniejszym. Po poprawnym wykryciu fiksacji i sakad analizuje się np. średni czas fiksacji, częstotliwość, amplitudę i kierunek drgań oka podczas fiksacji, prędkość i przyśpieszenie ruchów oka, czas trwania i trajektorię sakady. Dodatkowo interesujących informacji dostarcza analiza mrugnięć, ich częstości, czasu trwania oraz czasu zamykania powiek. Generalnie źródłem informacji cech osobniczych staje się korelacja: stymulacja (sygnał wejściowy oka) a ruch oka (odpowiedź), dzięki czemu można uzyskać powtarzalność wyników dla tej samej osoby, a więc poznać unikatowy wzorzec, na którym opiera się proces identyfikacji. Jak zatem dobrać odpowiednią stymulację? Najwygodniej zastosować wyświetlanie sygnału stymulacji na ekranie monitora. Oczywiście i z tym zagadnieniem wiąże się wiele istotnych problemów które należy wziąć pod uwagę przy projektowaniu systemu identyfikacji wykorzystującego ruch oka. Obecnie nie znaleźliśmy żadnej dostępnej aplikacji komercyjnej, tylko rozwiązania laboratoryjne, lecz z bardzo obiecującymi wynikami.

Rozpoznawanie ruchu ust (ang. lip movement recognition)

Rozpoznawanie ruchu ust wykorzystuje unikatowy sposób poruszania się ust podczas wypowiadania sekwencji słów przez każdą osobę.

W 1996 roku Japończyk Yoshiyuki Ominato zaproponował nowe podejście identyfikowania osób używających cech ruchu ust do sterowania dostępem. Poddany procesowi uwierzytelniania wypowiada określoną sekwencję słów. Proces ten jest nagrywany kamerą wideo. Z każdej klatki wideo rozpoznawany jest obszar zarysu ust na podstawie ich koloru z wykorzystaniem tzw. modelu HLS (HLS to jeden z modeli opisowych dla kolorów postrzeganych przez ludzi; polega na tym, że każdej barwie postrzeganej przez człowieka jest przyporządkowany jeden punkt w przestrzeni trójwymiarowej identyfikowany przez trzy składowe: H - ang. Hue - odcień, barwa, L - ang. Lightness - średnie światło białe, S - ang. Saturation - nasycenie koloru). Na podstawie tego zarysu określany jest stosunek szerokości ust do ich wysokości i w konsekwencji tzw. ramka brzegowa, będąca swoistym wizualnym wzorcem. Identyfikowanie następuje przez porównanie nowo uzyskanego wzorca z przechowywanym w bazie danych. Wyniki doświadczeń opartych na tej koncepcji wskazywały, że ta metoda jest wiarygodna, gdy wypowiedź jest w miarę długa.

Obecnie biometryczna spółka HumanScan AG oferuje wielomodalną biometryczną aplikację BioID wykorzystującą do automatycznej identyfikacji osób detekcję i rozpoznawanie twarzy, rozpoznawanie głosu i właśnie rozpoznawanie ruchu ust.

Produkt tej firmy jest przewidziany na różne ogólnoświatowe rynki, włączając bezpieczeństwo IT, bankowość, opiekę medyczną, administrację rządową, edukację i przemysł. Spółka ta prowadzi badania również w zakresie analizy gestów np. dłoni.

W kroku przetwarzania wstępnego charakterystyczne cechy biometryczne podlegają ekstrakcji z próbek, które są zarejestrowane przez zestaw wejściowych czujników, jak np. aparat fotograficzny, kamera i mikrofon. W zależności od konfiguracji aktualnie zarejestrowana próbka może składać się z:

- długich sekwencji wideo (przynajmniej 16 klatek),

- krótkich sekwencji wideo (dwie klatki) lub sekwencje próbek audio z częstotliwością próbkowania 22 kHz, 16 bitów.

Cechy biometryczne są uzyskiwane z dwu optycznych obrazów zarejestrowanych na wideo:

- ruchu ust (wypowiadanie słowa),

- twarzy.

By dokonać ekstrakcji tych cech, konieczne jest dokładne ustalenie pozycji twarzy. Ponieważ aplikacja ta powinna być użyteczna w dowolnym arbitralnym środowisku z wyposażeniem wideo seryjnych rozwiązań, proces znajdowania twarzy to jeden z najważniejszych kroków w procesie wydobycia cechy. Po przeprowadzeniu procesu lokalizacji twarzy i dokonaniu nagrania wideo aplikacja przeszukuje klatki zapisu w celu odnalezienia obszaru poruszających się ust (ruch ust jest zdeterminowany ściśle określoną wypowiedzią - hasłem). Obszar dookoła ust podlega ekstrakcji z pierwszych 16 klatek zarejestrowanego materiału wideo. Pozycja tego obszaru jest zdeterminowana wiedzą antropomorficzną, wykorzystującą odnajdywanie pozycji oczu w zdjęciu twarzy. Śledzenie całego obszaru twarzy z detekcją ruchu kompensuje niepożądane przemieszczenia spowodowane przez zmiany w pozycji głowy. Uzyskane klatki są obrabiane komputerowo w celu likwidacji szumów i wpływu oświetlenia (iluminacji). Następnie z każdego pojedynczego obrazu pobierany jest obszar dookoła ust, tak by odpowiadał prostokątnej formie, tzw. sztaludze. Sekwencja obrazów zawarta w sztalugach jest z kolei reprezentacją osobniczego wzorca jako cechy identyfikującej tożsamość.

Rozpoznawanie gestów (ang. gesture recognition)

Podstawowym celem badań rozpoznawania ludzkich gestów jest stworzenie systemu, który może zidentyfikować unikatowość ludzkiej gestykulacji i wykorzystać ją do kontroli dostępu.

Podobnie jak systemy rozpoznawania głosu czy analizy pisma odręcznego, systemy rozpoznające gesty, które są już używane, np. do sterowania komputerem i urządzeniami w środowisku lokalnym i odległym (telewizorem, oświetleniem itp.), są badane z tego samego powodu - aby dostarczyć metod projektowania systemom rozpoznającym tożsamość.

Gesty to pełne wyrazu, ekspresyjne, znaczące ruchy ciała - np. fizyczne ruchy palców, rąk, ramion, głowy, twarzy, albo całego ciała z zamiarem przekazania informacji albo oddziaływania wzajemnie na siebie ze środowiskiem naturalnym. Opisuje się trzy funkcjonalne role ludzkiego gestu:

- semiotyczny (semiotic) - by zakomunikować znaczącą informację,

- ergotynowy (ergotic) - by manipulować środowiskiem naturalnym,

- epistemologiczny (epistemic) - by odkryć środowisko naturalne przez dotykowe doświadczenie.

Rozpoznawanie gestu to proces, w którym gesty wyartykułowane przez osobnika są zauważone, rozpoznane i zidentyfikowane przez system. W badaniach McNeill i Levy (D. McNeill, E. Levy, Conceptual Representations in Language Activity and Gesture, 1982) zidentyfikowali gesty według własności fizycznych, które obejmują: konfigurację ręki, orientację dłoni i kierunek ruchu. Zauważają oni, że gesty składają się z fazy przygotowawczej, faktycznej fazy gestu i fazy odciągania. Z kolei inny uczony (Hauptmann) definiuje "ognisko" albo "centrum" gestu do zidentyfikowania i klasyfikacji trzech wymiarów gestów. Zatem należy zdefiniować, które aspekty gestu będą rozpoznawane przez sensory, i które posiadają unikatowy charakter. Z kolei sama koncepcja przeprowadzenia procesu uwierzytelniania z pewnością może być zaczerpnięta z istniejących już systemów rozpoznawania mowy czy podpisu odręcznego.

Literatura:

- Jani Ronkkonen: Video Based Gait Analysis In Biometric Person Authentication: A Brief Overview, Lappeenranta University of Technology, Finland.

- Mark Ruane Dawson: Gait recognition, Final Report, Department of Computing Imperial College of Science, Technology & Medicine, London, 2002.

- M. Andrzejkowicz, Możliwości wzbogacenia biometrycznej analizy chodu, Konferencja Naukowa Postępy w technice biometrycznej, Biometria 02.

- P. Kasprowski, J. Ober: Zastosowanie systemu pomiaru ruchu oka w biometrii, Konferencja Naukowa Postępy w technice biometrycznej, Biometria 02.

- Satprem Pamudurthy, Klaus Mueller - Department of Computer Science, E. Guan, Miriam Rafailovich - Department of Material Science and Engineering: A Dynamic Approach to Face Recognition.

- The Gesture Recognition Home Page: http://www.cybernet.com/~ccohen/gesture.html

- Image Processing Laboratory, Nara Institute of Science and Technology, Graduate School of Information Science, http://chihara.naist.jp

- Sign Assured, http://www.signassured.com

mgr inż. Paweł Niedziejko

mgr inż. Ireneusz Krysowaty

WAT